zurück zum Inhaltsverzeichnis

Expertengespräch zur genetischen Textkritik im Bereich Musik

Digitale Musikedition zwischen Werkstattdokument und Text

von Joachim Veit

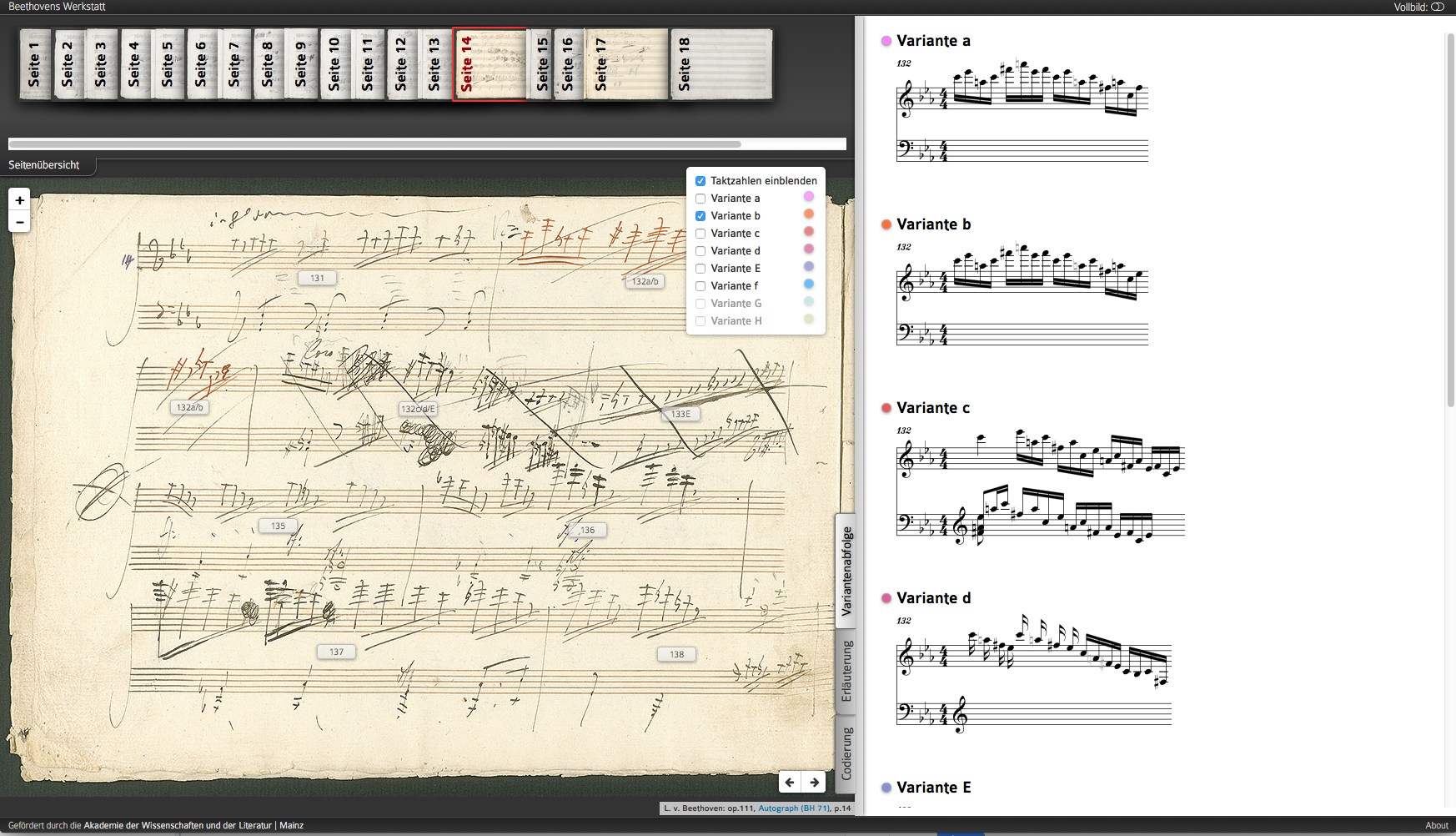

Im handschriftlichen Dokument kann die Skriptur als auf der Trägerschicht erstarrte Materialisation von Schreibprozessen bezeichnet werden – Versuche, durch die Interpretation der Metatexte in dieser erstarrten Landschaft Spuren von Leben zu entdecken, arbeiten sich zunächst am Dokument ab, indem durch Zeigen bzw. „Ansprechen“ von Details diese gedanklich in Beziehung gesetzt und hypothetisch Schreibprozessen zugeordnet werden. Das Prozesshafte lässt sich auf dem Papier mit viel und im Bildschirmmedium mit geringerem Aufwand einsichtig machen – Maja Hartwig und Johannes Kepper werden demonstrieren, inwieweit ein Dokument durch die im Projekt realisierten digitalen Zeigefunktionen die in ihm verborgenen Erkenntnismöglichkeiten preisgeben kann. 1 Entscheidend für den hier gewählten Ansatz ist dabei, dass durch dieses digitale Zeigen im Dokument kein „totes“ Objekt auf dem Papier angesprochen wird, sondern die gedankliche Interpretation – also das Identifizieren des Objekts als musikalisches Zeichen, die Zuordnung einer ihm anhaftenden logischen Bedeutung und das Fixieren seiner genetischen Position – nun auch explizit in einer formalen Sprache festgehalten werden kann und durch diese Verbindung ein operierender Zugriff auf allen drei Ebenen möglich wird.

Aber beim Übergang von der schriftbildlichen Skriptur des Dokuments bzw. von den darin (mit vielen Einschränkungen) wieder sichtbar zu machenden Schreibprozessen zu dem jeweiligen Produkt dieser Schreibprozesse, also zu dem resultierenden Noten-„Text“ ist, wenn dieser nicht bloß in seiner graphischen Gestalt, sondern für Rechneroperationen in seinem logischen Substrat dokumentiert werden soll, höchste Vorsicht geboten. In unserem Projekt entsteht aus dieser Notwendigkeit zur Überführung von Erkenntnissen in eine formalisierte, computerlesbare Sprache ein heilsamer Zwang zur Präzision, der den Gesetzmäßigkeiten formalisierter Sprachen geschuldet ist und keine Kompromisse zulässt. Dennoch: Ohne Kompromissbereitschaft können dabei in manchen Fällen Verarbeitungsprozesse so aufwändig werden, dass die Formalisierung keinen Erkenntnisgewinn mit sich brächte. Eine atomistische Detailgenauigkeit wäre kontraproduktiv: Zu viel Licht kann blenden und erkenntnisblind machen. Anhand der überschaubaren Beispiele der ersten Module kann und muss Beethovens Werkstatt deshalb diese Grenzlinie ausloten, um trag- und übertragungsfähige Lösungen zu entwickeln.

Aber die nach der Chronologie der Schreibprozesse geordneten temporären Notentext-Produkte, die wir im rechten Bildbereich unseres Prototypen abbilden, sind trotz ihrer (aufgrund von Rendering-Problemen) gegenwärtig noch unvollkommenen Gestalt wesentlich mehr als bloße „Transkriptionen“ des Prozessresultats auf Notenpapier: Sie sind in dem anfangs erwähnten Sinne als Texte funktional verbunden mit dem Dokument und aus der Codierung des logischen Substrats der dort (mit Hilfe der Metatexte) erschlossenen Textbewegungen erzeugt. (Daraus ergeben sich eine ganze Reihe von „Kollateralvorteilen“, die an dieser Stelle nicht erläutert werden können, die aber Thema der folgenden Diskussionen sein sollen.)

Auch die expliziten Metatexte bleiben in der Codierung erfasst und sind mit dem Dokument zeigend verbunden, im resultierenden Text dagegen sind sie gewissermaßen „ausgewertet“, indem z. B. die Kombination von Streichung und Ersetzung zu einer neuen Zeile Noten-„Text“ führt. Implizite Metatexte dagegen lassen sich zwar auch in die jeweilige Textrekonstruktion einbeziehen, in der Regel aber nicht formalisiert ablegen, sondern nur in separaten Anmerkungen beschreiben.